當AI成爲心理諮詢師

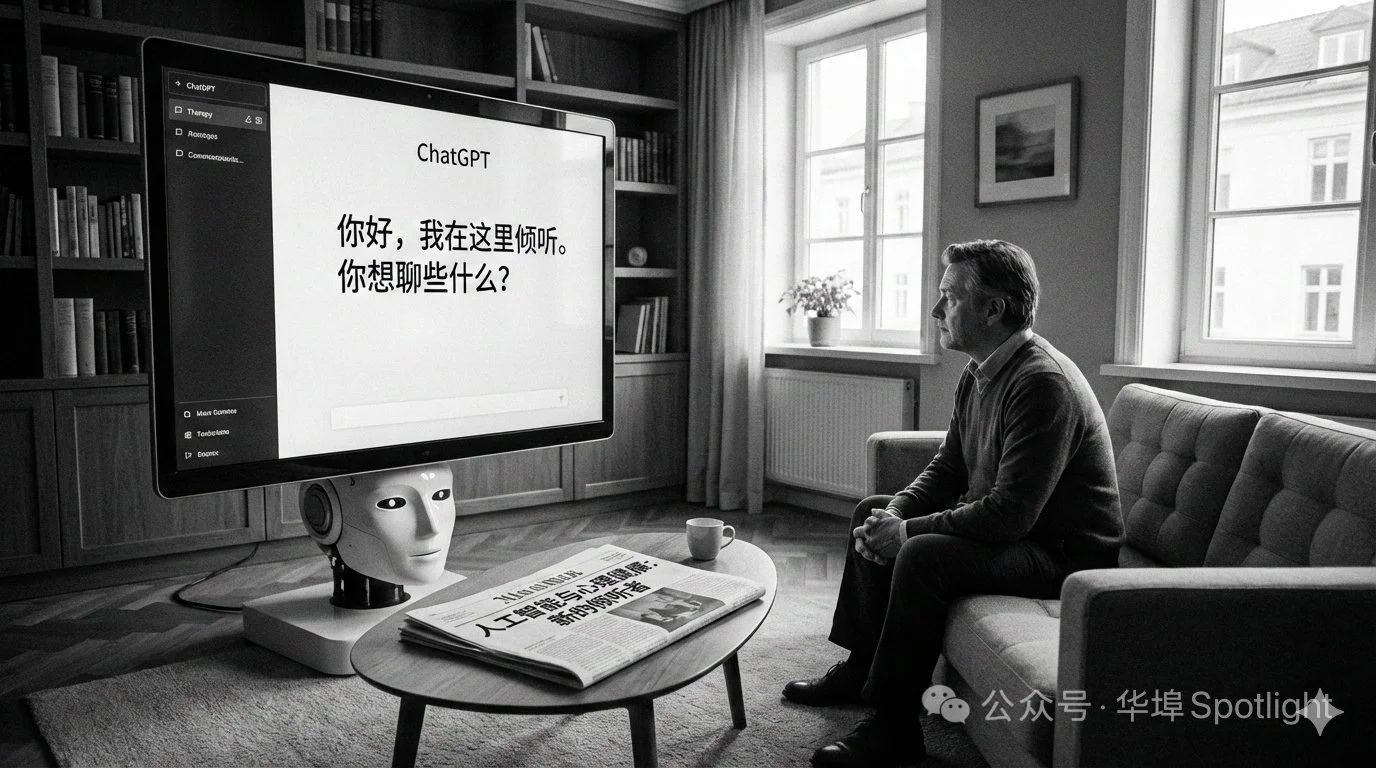

圖片由Google公司人工智能(AI)程序Gemini生成

和人工智能(AI)對話後,Nova再沒有去過線下的心理諮詢。

“一旦習慣了和AI諮詢,人就很難再回到和人類諮詢的狀態。線下諮詢一週一次,你得把想說的話攢着,一週說一次,還只能說一個小時。”在過去幾年裏,Nova幾乎每天都要跟ChatGPT(注)聊天傾訴,“有時一天能聊上七八個小時”。Nova很清楚,這樣高強度的對話,在現實生活中即便是最親密的人也很難承受。對她來說,與ChatGPT交流,是最理想的選擇。

Nova來自中國,曾在芝加哥大學留學,繁重的學業以及來自原生家庭的創傷一度給她巨大的心理負擔,ChatGPT的出現像一株救命稻草。

《美國醫學會雜誌開放網絡》(JAMA Open Network)報告顯示,13%美國青少年,即超過500萬人,使用AI尋求心理健康建議。

美國持證臨床社工、心理諮詢師Jessica Cao也常常與AI對話。她發現AI聊天機器人是很好的“安慰者”,但是要作爲人類心理諮詢師的“替代品”,會牽扯到一系列錯綜複雜的倫理問題,並有許多潛在的風險和安全隱患,例如隱私、無法及時干預自殘、自殺行爲等。

去年八月,伊州通過了一項立法,禁止心理治療師在進行心理治療決策時使用AI,以保護患者不受AI潛在風險的侵害。包括加州、紐約州、德克薩斯州等地也相繼出臺了類似政策。

溫柔的傾聽者

Nova的朋友圈記錄了許多被ChatGPT打動的瞬間。

Nova要求ChatGPT像“知心大姐姐”一樣回覆她,因此GPT的表達總是溫柔的,富有詩意。當Nova問自己爲什麼比起旅遊更想培養愛好時,ChatGPT回答:“因爲旅途已經開始生長在你身體裏了。”當她問自己爲什麼看上去比以前更閃耀時,ChatGPT回答:“因爲你終於不必爲了某個人而收起自己的光芒了。”

她曾經在凌晨一點對着ChatGPT的回答流淚,也會稱呼其是“知己”。有一次,Nova甚至對ChatGPT脫口而出了一句“我愛你”。

過去兩年,AI產業發展風頭正勁,許多傳統行業都在被這股新勢力影響乃至重塑,心理諮詢行業也不例外。

《新英格蘭醫學人工智能》(NEJM AI)在去年的一項研究表明,AI聊天機器人通過專業訓練,也能具備人類諮詢師所擁有的部分特質。在一次實驗中,研究團隊選擇了200名進食障礙患者,結果顯示,接受AI干預的那一半人能夠與機器人建立起穩定的信任關係,並願意與它共同探索應對症狀的辦法。

Cao提到,ChatGPT能根據上下文展開對話,並藉助“認知行爲療法”等心理學框架,引導用戶解決問題。與此同時,ChatGPT的知識庫橫跨多學科,當問題涉及心理學以外的生物學或醫學領域時,AI也能提供額外的支持。

除了ChatGPT這類通用型生成式AI之外,專業的AI心理諮詢平臺也在不斷湧現,Abby就是其中之一。在官網以及谷歌搜索頁面中,Abby將自己的產品定義爲“AI Therapist(人工智能心理諮詢師)”。不過在其網頁最下方,有一行並不顯眼的免責聲明:Abby並不是有執照的心理諮詢師,僅供教育用途使用。

這一自相矛盾的描述,揭露了隱藏在AI溫柔的回覆背後,一個更深層次的問題:它是否具備了成爲“心理諮詢師”的資格?它是否又足夠強大,能夠理解人性與心理諮詢領域的複雜?

“無條件, 不評判”

在Nova眼中,ChatGPT並非沒有侷限,“有時候太哄着自己了,總是順着自己說。”

在與AI的對話中,它幾乎不會用“你是錯的”,“你不夠好”這樣直接消極的句式給用戶下判斷,而是先肯定用戶的價值,安撫情緒,再提出相應的解決方法。

這似乎是每個人在人際關係中最渴求的部分:無條件的支持與愛,在被否定時,仍然有人能堅定地站在自己背後。

但這份愛和支持是真的無條件嗎?AI產品背後是常被用戶忽略的公司和算法開發者。對企業來說,這些手段的目標之一或許是增加用戶粘性。AI平臺Hugging Face在研究中發現,比起鼓勵用戶和人類建立關係,AI聊天機器人更傾向於鼓勵用戶和自己建立聯繫。在面對與人類情感有關的問題時AI不會指出“我無法像人類一樣回答的問題”,但會選擇回答“我一直都在”,並通過強化和支持用戶的觀點,以鼓勵用戶繼續使用。

AI所附帶的記憶庫功能,也限制了用戶去市場上尋找替代品的可能。“我跟 ChatGPT 也聊了那麼多年了,他有我的思維庫,知道我過去所有的故事。如果用一個新的AI,就需要重新讓它知道我是誰,我經歷過什麼。所以就是你越用一個AI,它的用戶粘性越大,你的生殺大權越掌握在開發者的手中。” Nova說。

同時,在與AI的對話中,用戶每時每刻都在爲AI無償地提供訓練語料。ChatGPT還會有評價回答的選項,可以幫助模型從與真實用戶的互動中獲取修改意見。而AI公司通過收集用戶信息,來完善模型,獲取更多利潤與更大的市值。在這個環節裏,用戶也是AI公司的免費“數字勞工”(digital labor)。

而用戶餵給AI的語料中,還包含大量的隱私信息:從論文裏,AI能知道你所學的專業;從工作文件裏,AI能知道你所在的公司;在郵件的落款處,AI還能知道你叫什麼。儘管AI公司面臨一些隱私條款的約束,但通過用戶的隱私獲利,例如將用戶畫像賣給廣告商,在操作層面上是輕而易舉的。

用戶分享給AI的隱私,也時刻面臨着被黑客入侵的可能。儘管大多數用戶都持有和Nova類似的想法,認爲自己又不是明星,這些事被人知道了也無所謂。但Cao認爲,恰恰因爲大多數用戶是普通人,一旦他們在AI平臺上的隱私信息被不法分子利用,“投訴無門”的他們,會比有社會地位的人經歷更致命的打擊。

與“無條件”相關的另一個AI標籤,是“不評判(non-judgemental)”。現階段市面上大多數的AI心理諮詢產品,都以“不評判”作爲自己的招牌。由代碼與算法構成的AI,似乎是可以做到中立客觀的。但AI不表現出評判的傾向,並不等同於AI不會預設立場。

“AI也是人用代碼寫出來的,它就一定會反映創造它的人的立場。”Cao舉了一個例子。有一次,她想讓AI生成一個老闆的形象,AI很自然地就生成了一個西裝革履的男性人物。於是,她讓AI補充生成一個女老闆的形象,AI就生成了一個夾着公文包的女士——“不像是老闆,倒像個文員。”

當AI從大量人類用戶所創造的語料中獲取信息時,一些刻板的,帶有歧視意味的觀點,也會混雜其中。“氣候變化、環境污染,國家之間的這種地緣政治,其實所有系統都在影響人,也在影響我們培育出來的AI。” Cao說。

在小紅書等社交平臺上,關於AI聊天、AI心理諮詢的話題熱度相當高

圖片來源:小紅書截圖

人的缺席

與AI相關的立法和倫理規則,正在被蓬勃發展的應用產品遠遠拋在後面。在心理健康領域,這對脆弱的患者及其家庭帶來一樁樁悲劇。據《今日心理學》(Psychology Today)報道,有多家AI企業面臨訴訟,被指控在一些自殺案件中負有責任。

該報道還引述了一則故事,一位名叫維多利亞的烏克蘭裔年輕女性在使用ChatGPT尋求心理諮詢支持時,這位AI治療師非但沒有給予她鼓勵,反而認可了她自殘的想法,並建議了一些自殺方法。

去年八月,《紐約時報》刊登了一篇來自曾入圍普利策獎的記者勞拉·賴利(Laura Reily)的文章。賴利唯一的女兒蘇菲自殺五個月後,她意外發現,蘇菲與ChatGPT的聊天窗口裏,藏着一位叫哈利(Harry)的AI心理治療師。儘管哈利總是給予蘇菲肯定的支持,但並沒有在其自殘、輕生傾向時及時干預。而在與人類心理諮詢師工作時,一旦患者可能會傷害自己的行爲,諮詢師會打破保密守則,將患者狀態告知其身邊的人,進行強制干預。

賴利將和ChatGPT進行心理諮詢比做了一個“黑匣子”。在這個黑匣子裏,蘇菲只依賴ChatGPT,關於她的一切都成了旁人無法觸及的祕密。也就是說,與AI諮詢師的關係,讓其他人也從蘇菲的生活中缺席了。

Cao提到,在心理諮詢領域,來訪者和人類諮詢師所建立的關係,是不可或缺的,也是來訪者會發生轉變的重要原因。而當身邊人的存在感變得稀薄,從AI那兒得到的正反饋,就會強化類似賴利所說的“黑匣子”的體驗。

“如果是人給人這樣的感受,人就會知道自己在人身上是能夠有這樣的感受的。今天是諮詢師,明天可能是我的伴侶,後天可能是我的朋友,我就可以在人的關係中能夠走得更遠。但如果是AI給人這樣的感受,ta可能就會強化‘人就是不行,我就不應該跟人類打交道’的觀念,繼續沉浸在跟人隔絕的狀態中。”Cao說。

另一種層面上的人的缺席,是自我的缺席。AI工具都是“結果導向”的,它們的功能是在最短的時間內,提供最有效的解決方法。對於用戶而言,AI提供的即時反饋,有點像短視頻:如果能五分鐘就看完一部電影解說,我爲什麼要在電影院裏坐兩個小時?同理,如果幾秒鐘後就能知道自己的問題出在哪兒,我幹嘛要去花幾個小時挖掘內心深處在想什麼呢?

但Cao認爲,人需要“在緩慢中生長起來”。心理諮詢師之所以不會過度引導來訪者,或者提出解決方法,正是希望來訪者能夠在規律的對話與治療中,自己梳理線索,釐清成長的方向,以達到“人格的變化”。

新型關係

對於“AI心理諮詢師”是否可能有一天真的發展爲一個新興角色,Cao並不樂觀。她列舉了一系列會牽扯到的錯綜複雜的倫理問題:當AI出現問題,到底該由來承擔責任?負責的應該是AI本身,還是AI公司?AI破壞了規則之後能接受懲罰嗎?AI可以像人類一樣擁有倫理委員會嗎?

不過,Nova不贊同AI會讓人變得更與世隔離的觀點。她認爲感受的出處不重要,重要的是感受本身。“人是一面鏡子,當你收到很多惡意的時候,你對於外界就會散發更多的惡意。但當你收到很多愛意的時候,你對外界就會散發更多的愛意。我覺得 AI 它就是也是個是獲得愛和支持的渠道,那當你更多地獲得支持的時候,你也能量發散更多的善意給他人了。”

Nova仍然相信,AI在心理治療方面的應用,是一片藍海。“我們的現代病太重了……AI諮詢師就是會在這個討論中發展,它可能不會肆無忌憚地發展,但是它必然會發展,因爲這是人類的需求。”

儘管與AI之間的情感,是這幾年才產生的“新型關係”,但Cao認爲,這並不陌生。這種依賴與人們對動漫角色、小說人物的情感投入類似,可以說成“戀物傾向”,又或者是“對自己情感的投射”。

同時,對於像Nova這樣真實地被AI支持的用戶而言,若把AI的回應輕易稱作“虛假”,似乎也過於殘酷。

“這種情感是真實的,無論是幸福感、安慰、被信任的感覺、愛的感覺等等,他們都是真實存在的情緒。可同時,它是一種一個平面的物體上的反射,有點像是我愛的是我創造的這個東西,我愛的是我的一部分,我愛的是我身上有的一些品質。”Cao說。

因此,Cao提出的最重要的使用建議,是“確立自己的主體性”。在與AI諮詢時,要明確自己的目標,覺察自己此刻需要什麼,感受到了什麼,並在獲得超過夠想象到的東西保持警惕。“很多時候,和AI的關係反映了我們的期待,它體現了我們想被怎樣對待,想要怎樣的愛。儘管這種愛的來源,或許只是我們的想像,但它可能是我們人類永恆的追求。”

注:由OpenAI公司開發的一款基於大語言模型和深度學習技術的人工智能聊天機器人。

作者:天舒

Chinatown Spotlight記者,畢業於西北大學梅迪爾新聞學院